MapReduce、Hadoop、Storm、Spark……这些名字你一定不会陌生。没错,它们都是用于处理大规模数据的技术。这还只是其中的一部分,我们可以继续往后列:Kafka、Google Cloud Dataflow、Flink、Beam…

应用介绍

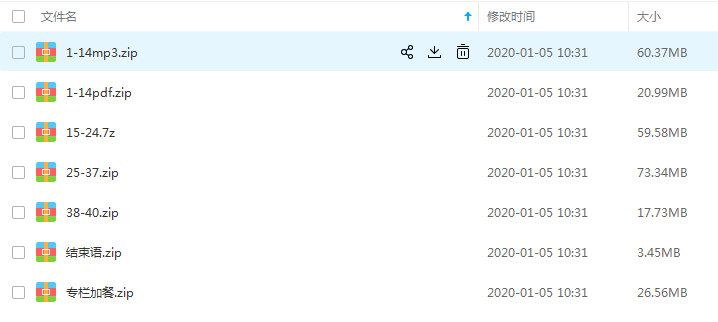

《大规模数据处理实战》课程目录

模块一:直通硅谷大规模数据处理技术

1.为什么MapReduce会被硅谷一线公司淘汰?

2. MapReduce后谁主沉浮:怎样设计下一代数据处理技术?

3.大规模数据处理初体验:怎样实现大型电商热销榜?

模块二:实战学习大规模数据处理基本功

4.分布式系统(上):如何用服务等级协议SLA来评估你的系统?

5.分布式系统(下):架构师不得不知的三大指标

6.如何区分批处理还是流处理?

7.Workflow设计模式:让你在大规模数据世界中君临天下

8.发布/订阅模式:流处理架构中的瑞士军刀

9. CAP定理:三选二,架构师必须学会的取舍

10.Lambda架构:Twitte「千亿级实时数据分析架构背后的倚天剑

11.Kappa架构:使用Kafka锻造的屠龙刀

模块三:抽丝剥茧剖析Apache Spark设计精髓

12. Spark的独有优势:为什么世界需要Spark?

13.弹性分布式数据集:Spark大厦的地基为何如此设计(上)

14.弹性分布式数据集:Spark大厦的地基为何如此设计(下)

15.Spark SQL: Spark数据查询的利器

16.如何用Spark DataFrame API进行实时数据分析?

17.Spark Streaming: Spark 的实时流计算 API

18. WordCount:从零开始运行你的第一个Spark应用

19.综合案例实战:力口州房屋信息的线性回归模型&成年人收入的预测模型

20.更多、更快、更好、更省:实例解析Spark应用程序性能优化

21.深入对比Flink与Spark:帮你的系统设计两开花

模块四:Apache Beam为何能一统江湖

22.Apache Beam的前世今生

23.站在Google的眉膀上学习Beam编程模型

24. PCollection:为何Beam要如此抽象封装数据?

25. Beam数据转换操作的抽象方法

26. Pipeline: Beam如何抽象多步骤的数据流水线?

27. Pipeline I/O: Beam数据中转的设计模式

28.如何设计好一个Beam Pipeline?

29.如何测试Beam Pipeline?

模块五:决战Apache Beam真实硅谷案例

30. Apache Beam 实战冲刺:Beam 如何 run everywhere?

31.WordCount Beam Pipeline 实战

32. Beam Window:打通流处理的任督二脉

33.横看成岭侧成峰:再战Streaming WordCount

34. Amazon 热销榜 Beam Pipeline 实战

35.Facebook游戏实时流处理Beam Rpeline实战(上)

36.Facebook游戏实时流处理Beam Rpeline实战(下)

模块六:大规模数据处理的挑战与未来

37. 5G时代,如何处理实时超大规模物联网数据?

38.大规模数据处理在深度学习中如何应用?

39.从SQL到Streaming SQL:突破静态数据查询的次元

40.总结与答疑

发表评论 取消回复